Постоянно сталкиваюсь с такой ситуацией: мне дают падающую в трафике зафильтрованную страницу для детальной проработки, и когда я прошу предоставить семантическое ядро, под которое она писалась, присылают 5-6 запросов, взявшихся непонятно откуда (чаще всего, из больной фантазии бывшего СЕО-шнега). Я тут же забиваю «маску» в Wordstat и вижу, что подходящих для продвижения ключей листать — не перелистать.

Для меня диагноз становится очевиден – мания величия. Чем иначе объяснить желание занять первые позиции, когда у тебя нет даже толкового семантического ядра? В такой ситуации я предлагаю отодвинуть детальную проработку на второй план и собрать семантику по максимуму. Хотя подобное предложение часто встречают «в штыки», потому что заказчики думают, будто я пытаюсь «высосать» побольше денег. Составление семантического ядра – действительно дорогая работа, не только потому что ответственная, а еще и потому что приходится задействовать много платных сервисов. Эту инструкцию о том, как составить семантическое ядро, я решил написать специально для тех, кто обвиняет SEO-шников в крохоборстве. Она довольно подробная и с примером, так что поможет собрать запросы любому, кто разбирается хотя бы на уровне дилетанта.

Оглавление

Что такое семантическое ядро?

Начнем с азов. Семантическое ядро – это набор запросов, под который мы будем оптимизировать конкретную страницу. Оно должно быть готово еще до того, как мы приступим к созданию контента для страницы. Семантическое ядро позволит нам упростить решение сразу двух задач:

- Мы составим список разделов страницы, проанализировав список запросов.

- Мы сделаем техническое задание на SEO-копирайтинг – опять же на базе пула наших слов.

Писать контент без семядра – это называется «вилами по воде». Мы пытаемся давать ответы, не зная вопросов. С семантическим ядром мы можем понимать, что конкретно интересует людей, и знать приоритетность их интересов – после определения частотности. Если, скажем, ключ «обработка горячим туманом» имеет частотность в 10 раз выше, чем «обработка холодным туманом», мы понимаем, что в тексте лучше делать акцент на горячий туман.

Семантическое ядро сайта – это перечень всех запросов, под которые будут оптимизироваться все страницы ресурс. Как правило, такой перечень довольно обширный, поскольку нет смысла делать свой сайт, если тема народ не интересует. Семантика кластеризуется программным способом, и на основе разбитых по группам запросов можно уже составлять структуру. Если же семантики нет или она не разбита по кластерам, мы будем подходить к разработке структуры примерно так:

Сразу оговорюсь, что лучше собирать семантическое ядро сайта целиком. Однако в некоторых случаях требуется сбор семантики для конкретной страницы – например, когда нужно подтянуть на нее трафик. Данная инструкция – для таких случаев. О том, как собрать семантическое ядро для сайта – расскажу потом. Ждите.

Семантическое ядро: как составить правильно?

Запаситесь терпением, платными сервисами и строго следуйте инструкции, которую я для вас написал.

Шаг 1. Определить высокоуровневые маски

Не хочется опускать вас в чан с банальностями, но высокоуровневые маски – фундамент, на котором возводится, как дом, семантическое ядро страницы. Ошибка на этом этапе обходится очень дорого. Так что будьте внимательны, сконцентрируйтесь и поймайте дзен.

Высокоуровневые маски – то же самое, что и запускающие ключи (или вход). Это пул запросов, обычно высокочастотных, которые мы будем парсить.

Три главных источника, откуда можно взять высокоуровневые маски: выдача, Keys.so, а также…

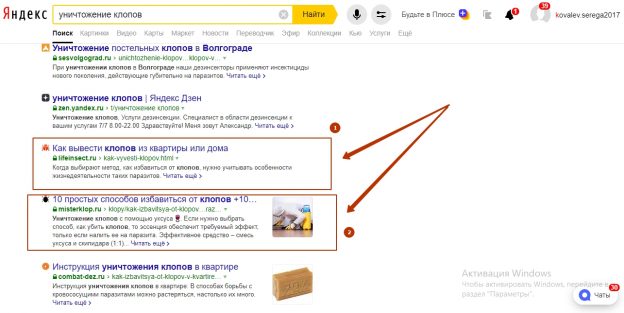

Для примера того, как составить семантическое ядро, возьмем тему, с которой я недавно работал: уничтожение клопов. Семантика, которую мне дали, выглядела вот так:

Далеко не самое худшее, с чем мне приходилось сталкиваться, но резервы есть.

По семантике видно, что на вход подали только запрос уничтожение клопов. Я же попробую подсобрать больше.

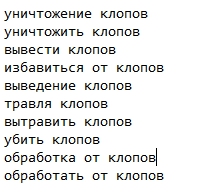

Итак, первым берем уничтожение клопов. Тут же дополняем маской уничтожить клопов, поскольку с точки зрения семантики «существительное» не равно «глагол». Дальше отправляемся в выдачу. Смотрим на тайтлы и видим еще 2 любопытных варианта: вывести клопов и избавиться от клопов.

Вывести клопов также превращаем в выведение клопов. В сниппетах я нашел варианты вытравить клопов и убить клопов. Дополнил маской травля клопов. На этом с выдачей все, но восемь высокоуровневых масок — уже неплохо.

Далее идём в Keys.So. Это сервис для парсинга ключевых слов, по которым продвигаются конкуренты. Здесь надо ввести адрес страницы конкурента в строку и нажать «Анализировать».

Просматриваем перечень из семантического ядра конкурента на предмет интересных коротких комбинаций, которые мы упустили из виду. Я, например, в Keys.So нашел вариант обработка от клопов. Его же преобразовал в обработать от клопов.

Третий источник – воображение – я подключить попытался, но не дало плодов, поскольку в теме дезинсекции я профан. Если вы в теме не «шарите», едва ли сможете предложить что-то толковое – только изнасилуете свой мозг. Лучшее, что можно здесь сделать – изнасиловать мозг другому, то есть найти эксперта в теме и провести с ним беседу. С подобной практикой я сталкивался, когда работал в SEO-отделе бухгалтерской компании.

В общем-то, и так неплохо – 10 высокоуровневых масок вместо одной. Чувствуете разницу?

Шаг 2. Распарсить маски по максимуму

Есть две основные стратегии парсинга:

- Подать список высокоуровневых масок на парсинг в KeyCollector (Словоеб, Магадан) и потом руками чистить то, что парсер собрал.

- Сделать парсинг в Wordstat и выбирать только то, что подходит.

Несмотря на то что ленивые SEO-шники знают, как собрать ядро, только по первому пути, я все же считаю, что работа с Wordstat эффективнее – хотя, безусловно, и трудозатратная. Притом я абсолютно уверен, что сил на чистку семантики из KeyCollector и ручной сбор в Wordstat уходит одинаковое количество.

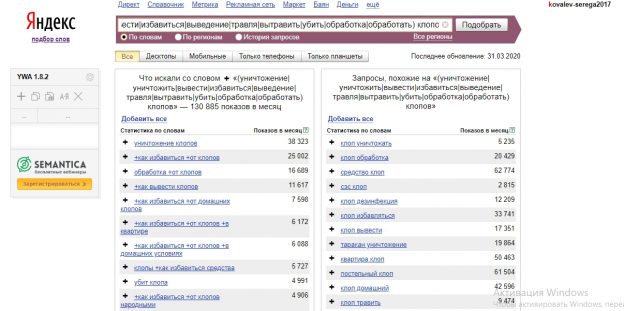

Глядя на нашу сборку, мы видим, что во всех масках присутствует слово «клопов» и что все они двухсловные. Так что мы можем «вбить» в строку Wordstat следующее:

(уничтожение|уничтожить|вывести|избавиться|выведение|травля|вытравить|убить|обработка|обработать) клопов

Напомню, что вертикальная черта – это оператор «или». Если мы введем такое сочетание, то выведем в Вордстат все запросы по найденным нами маскам.

Дальше из списка уже руками выбираем то, что нам подходит. Плюсуем только коммерцию (нет «информационке») и только с подходящими топонимами (исключаем, например, запросы с «СПб»).

Мы плюсуем слова, содержащие указание на коммерческий характер запроса – купить, заказать, услуги, цена и так далее. Обходим стороной ключи вроде «как избавиться от клопов самостоятельно» и «как избавиться от клопов народными средствами». Логика понятна – наша страница рекламная, мы продаём услугу, а не народные методики. И уж точно не собираемся учить людей выводить клопов. Если невозможно определить, является он коммерческим или информационными, мы его добавляем. На этом этапе – этапе сбора семантического ядра – важно собрать слов по максимуму. Лишнее все равно уйдет на этапе чистки.

Шаг 3. Отбросить низкочастотку

Один мой знакомый SEO-шник рассказал мне, как реализуется принцип Парето (80/20) в интернет-продвижении. Если «ядрышко» достаточно обширное и собрано правильно, то 20% запросов содержат примерно 80% частотности. Оставшиеся 80% запросов – соответственно 20% частотности. Фактически это означает следующее: потратив 20% времени на продвижение наиболее частотных запросов из семантического ядра, можно получить 80%-ный результат. Если хочешь 100%-ный результат, придётся потратить в 5 раз больше времени на то, чтобы ковыряться с «низкочастоткой».

Я всегда следую этой гипотезе, когда собираю семантические ядра – для всего сайта целиком или для крупного раздела. Когда собираешь семантику для одной страницы, не обязательно фанатично высчитывать порог частотности, на котором заканчиваются 20% и начинаются 80%. Этот порог можно взять за константу для конкретной тематики. В большинстве случаев я отбрасываю все запросы, у которых очень точная частота («!YW») меньше 10. В тематиках, где ключевиков мало в принципе и нужна более глубокая проработка, оставляю все фразы с «!YW» больше 5.

Менее частотные фразы есть смысл прорабатывать, только если продвигаешь Landing-Page. Специфика лендингов такова, что продвинуть их по ВЧ- и НЧ- почти невозможно.

Удаление «низкочастотки» из семантического ядра через KeyCollector правильнее всего производить так:

- Вычисляем «кавычковую» частоту и удаляем все запросы, у которых «YW» меньше порога (например, 10).

- У оставшихся вычисляем частоту с восклицательным знаком.

- Пробегаемся глазами, ищем, есть ли запросы с большой относительной разницей между «YW» и «!YW» (больше 50%).

- Если таких нет, то удаляем все запросы, у которых «!YW» меньше порога.

Зачем искать запросы с большой разницей между частотностями? Чтобы случайно не упустить качественный запрос из-за того, что его забили в Коллектор в неоптимальной словоформе. Напомню, «!YW» — частотность точной словоформы, а «YW» — частотность состава словоформы независимо от того, в каких падежах и числах употребляются составляющие слова. Например, у двух ключевиков «уничтожение клопов» и «уничтожение клопа» будет одинаковая «YW» — а вот «!YW» у первого будет гораздо выше.

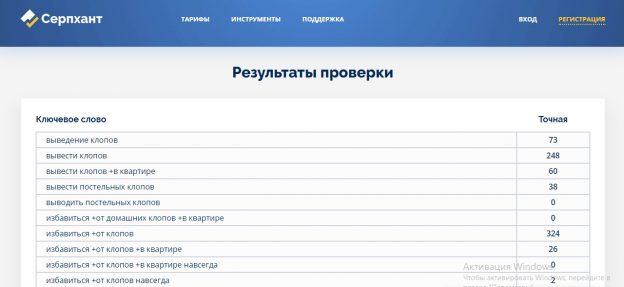

Если KeyCollector у вас нет, не повод отчаиваться. Можно воспользоваться бесплатной альтернативой – программой SlovoEB. Правда, пока он закончит проверку, вы перегрызете коллег все ногти. Моя личная находка – онлайн-сервис Серпхант. Довольно быстро определяет частотность небольшого семантического ядра. Кроме того, работает бесплатно и без регистрации.

Минусы этого способа:

- Нет возможности вычислить «кавычковую» частотность – только YW и «!YW».

- Нет экспорта в файл Excel – только COPY / PASTE.

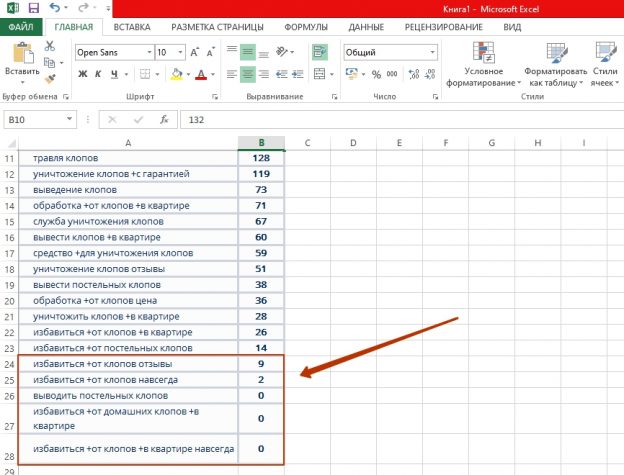

На скрине уже видим, что в нашем импровизированном варианте есть запросы-«нулевки». Копируем данные в Excel, сортируем по убыванию частотности и смело отбрасываем те, у которых «частотка» меньше 10.

Шаг 4. Кластеризация семантического ядра

Кластеризация – по сути следующий этап составления семантического ядра. На этапе сбора в Wordstat я намеренно допустил ошибки, взяв лишние, некоммерческие запросы. Это не потому, что я болван. Просто хочу показать, чем полезна кластеризация.

Кластеризация позволяет нам разбить запросы по группам, которые, по мнению поисковика, должны соответствовать одной странице.

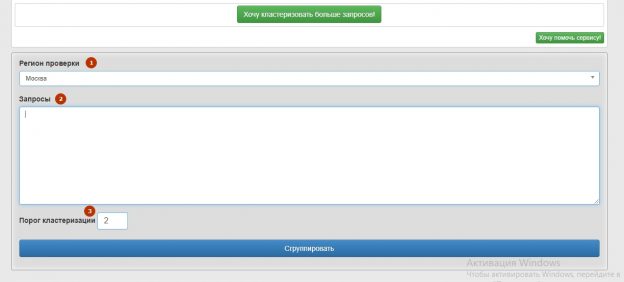

Пул запросов, который остался после чистки по частотности, мы разбиваем по выдаче. Если пул небольшой (до 1000 запросов), я всегда использую бесплатный сервис Кулакова, потому что он, как я уже сказал, бесплатный, быстрый и еще он бесплатный. Меня никогда не подводил. Использовать его просто: выбираешь регион проверки (1), копируешь все запросы в окошко (2), выставляешь порог кластеризации (3) и жмешь «Сгруппировать».

Затруднения может вызвать, пожалуй, порог кластеризации. По сути это количество URL, которые по группе запросов должны быть в десятке – соответственно, чем выше порог, тем более детальным будет деление. Я советую не мельчить: если кластеризуете информационный сайт, ставьте 2, если коммерческие запросы – то лучше 3.

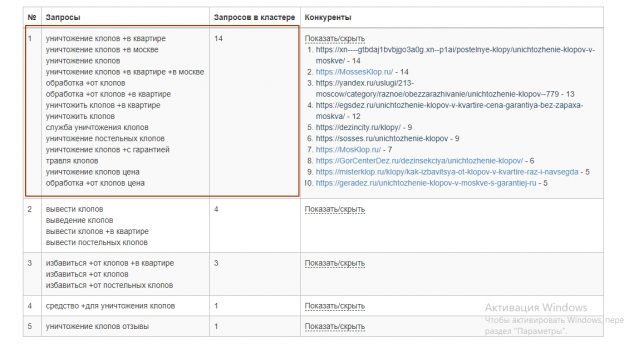

Посмотрим, как «Кулаков» разбил наших клопов:

Запросы со словами «отзывы» и «средство» остались в стороне. Плюс отбросим еще 2 пула: со словами «вывести» и «избавиться». Наша проверка дала понять, что выдача по этим запросам информационная. Как я это понял? Раскройте вкладку «Показать / скрыть» в колонке «Конкуренты», просмотрите, какие сайты в выдаче – вам все тоже станет понятно.

Пул из 23 запросов мы сократили до 14. Будет ли это нашим окончательным семантическим ядром? Возможно. Но нужно сделать еще одну проверку.

Шаг 5. Парсинг подсказок Яндекс и Google

В подсказках тоже может быть много чего интересного. Например, слова, задающие и расширяющие тематику. Иногда (но редко) встречается толковый «многословник».

Чего нам нужно тут делать? Мы:

- Копируем все 14 наших слов из отчета «Кулакова» в KeyCollector (да, обратно).

- Клацаем на кнопку парсинга подсказок – три разноцветных шарика (у меня, увы, сейчас доступа к KK нет – так бы показал).

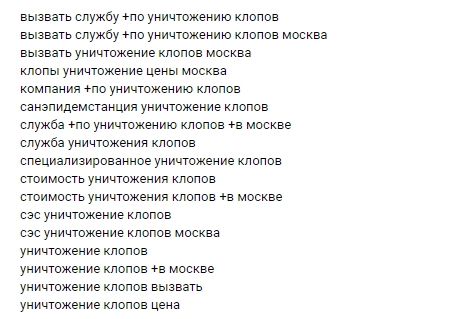

- Выбираем из ядра те запросы, которые больше всего похожи на высокоуровневые маски – или, проще говоря, короткие. В нашем примере это «уничтожение клопов», «обработка от клопов», «травля клопов» и «уничтожить клопов». Подаем их на парсинг и ждем.

Скопировать в KeyCollector все ядро было необходимо, чтобы парсер не добавлял в качестве подсказок запросы, которые уже присутствуют в нашем ядре – например, «уничтожение клопов в квартире». По умолчанию Коллектор настроен так, что дубли не добавляет. Кроме того, нам нужно получить частотность запросов окончательного семядра – по мне, так лучше ее снова снять, чем ВПР-ить.

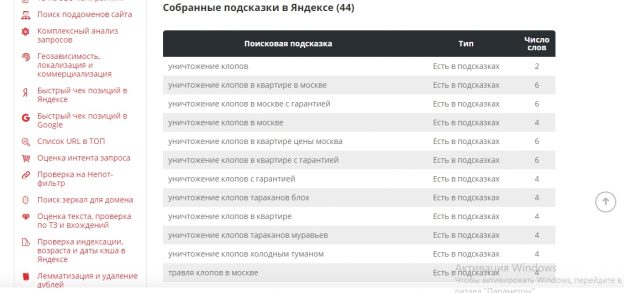

Почти наверняка KK найдет несколько подсказок из Google и сотню из Яндекс. Снимаем частотность «!YW» у всех. Если есть запросы с «!YW» более 9, добавляем к нашему ядру. Если нет – что ж, гипотеза проверена, отрицательный результат – тоже результат!

Если у вас нет KK, как альтернатива сгодится этот инструмент от PixelPlus – правда, он парсит подсказки только из «Яши». Мне нашёл 44 подсказки, но среди них были запросы, которые я уже взял.

Поиск подсказок мне помог. После чистки я обнаружил, что ядро выросло почти вдвое – до 27 запросов. Если кому интересно, «ядрышко» я приложу ниже – как пример.

Пример семантического ядра

А дальше-то что?

Дальше это семантическое ядро нужно передать SEO-специалисту, который знает, как правильно составить техническое задание для копирайтера. Либо, возможно, в вашей компании создание заданий на тексты возложена на специального ТЗ-мейкера (прости, Господи). Но обычно человек, который собирает семант, и человек, который готовит ТЗ – это разные люди. Хотя по опыту могу сказать, что патологии организационных структур в России способны порождать самые извращенные совмещения обязанностей.

Кстати, статья по то, как сделать ТЗ для копирайтера, у меня на сайте тоже есть – вот она. Почитайте: там такой же подробный, на пальцах разжёванный мануал, как и здесь.

И в конце дайте уж порекламироваться самому:

Собираю семантическое ядро для сайта целиком, раздела, страницы. Парсю, все что парсится. Упущенный запрос воспринимаю как личную трагедию. Гарантирую самый полную семантику. Собрать семантическое ядро для одной страницы – 500 рублей. Цену более объемных работ с удовольствием обсужу в личном общении. Пишите: Почта – serkov1991@rambler.ru Skype – seryi0291